Die Auflösung ist die Fähigkeit eines Bildgebungssystems, die Details eines Objekts zu reproduzieren, und hängt von Faktoren wie der Art der verwendeten Beleuchtung, der Pixelgröße des Sensors und den Fähigkeiten der Optik ab. Je kleiner das Detail des Motivs ist, desto höher ist die erforderliche Auflösung des Objektivs.

Einführung in den Lösungsprozess

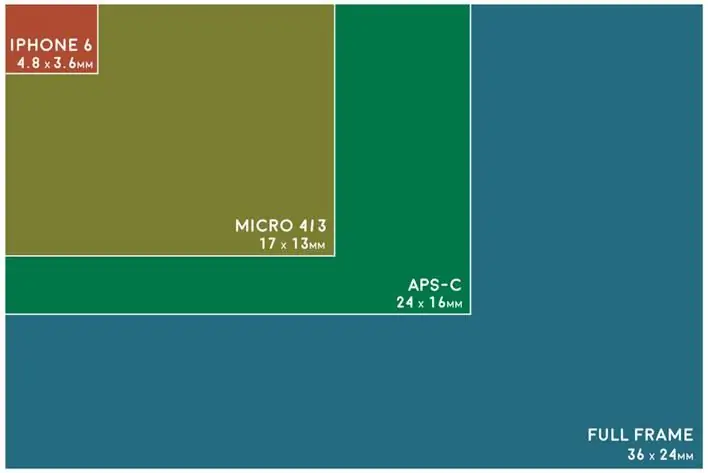

Die Bildqualität der Kamera hängt vom Sensor ab. Einfach ausgedrückt ist ein digitaler Bildsensor ein Chip in einem Kameragehäuse, der Millionen von lichtempfindlichen Punkten enthält. Die Größe des Sensors einer Kamera bestimmt, wie viel Licht verwendet werden kann, um ein Bild zu erzeugen. Je größer der Sensor, desto besser die Bildqualität, da mehr Informationen gesammelt werden. Typischerweise werben Digitalkameras auf dem Markt für Sensorgrößen von 16 mm, Super 35 mm und manchmal bis zu 65 mm.

Mit zunehmender Größe des Sensors nimmt die Schärfentiefe bei gegebener Blende ab, da man bei einem größeren Gegenstück näher ran mussObjekt oder verwenden Sie eine längere Brennweite, um den Rahmen auszufüllen. Um die gleiche Schärfentiefe beizubeh alten, muss der Fotograf kleinere Blenden verwenden.

Diese geringe Schärfentiefe kann wünschenswert sein, insbesondere um Hintergrundunschärfe für Porträtaufnahmen zu erzielen, aber Landschaftsfotografie erfordert mehr Tiefe, die mit der flexiblen Blendengröße von Kompaktkameras einfacher einzufangen ist.

Das Teilen der Anzahl horizontaler oder vertikaler Pixel auf einem Sensor gibt an, wie viel Platz jeder einzelne auf einem Objekt einnimmt, und kann verwendet werden, um das Auflösungsvermögen der Linse zu bewerten und Kundenbedenken hinsichtlich der Pixelgröße des digitalen Bildes des Geräts auszuräumen. Als Ausgangspunkt ist es wichtig zu verstehen, was die Auflösung des Systems tatsächlich einschränken kann.

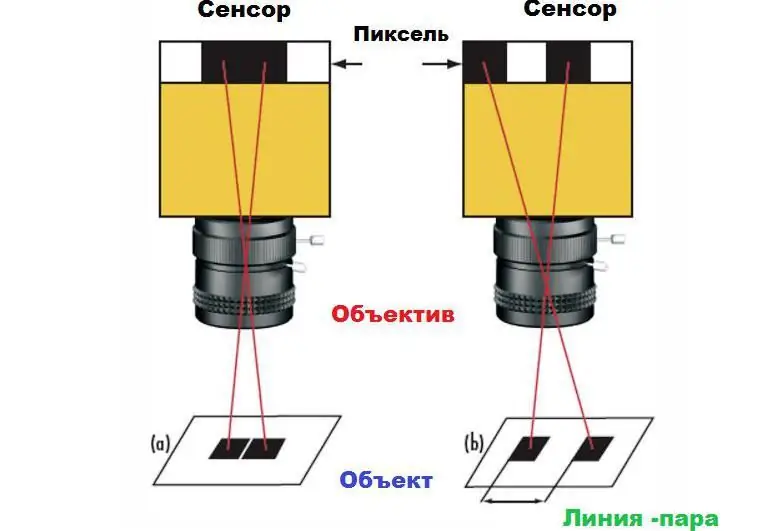

Diese Aussage lässt sich am Beispiel eines Quadratpaares auf weißem Grund demonstrieren. Wenn die Quadrate auf dem Kamerasensor auf benachbarte Pixel abgebildet werden, erscheinen sie im Bild als ein großes Rechteck (1a) und nicht als zwei separate Quadrate (1b). Um die Quadrate zu unterscheiden, ist ein gewisser Abstand zwischen ihnen erforderlich, mindestens ein Pixel. Dieser Mindestabstand ist die maximale Auflösung des Systems. Die absolute Grenze wird durch die Größe der Pixel auf dem Sensor sowie deren Anzahl bestimmt.

Objektiveigenschaften messen

Die Beziehung zwischen abwechselnd schwarzen und weißen Quadraten wird als lineares Paar beschrieben. Typischerweise wird die Auflösung durch die Frequenz bestimmt,gemessen in Linienpaaren pro Millimeter - lp/mm. Leider ist die Objektivauflösung in cm keine absolute Zahl. Bei einer gegebenen Auflösung hängt die Fähigkeit, die beiden Quadrate als separate Objekte zu sehen, von der Graustufenstufe ab. Je größer die Graustufentrennung zwischen ihnen und dem Raum ist, desto stabiler ist die Fähigkeit, diese Quadrate aufzulösen. Diese Unterteilung der Grauskala ist als Frequenzkontrast bekannt.

Ortsfrequenz wird in lp/mm angegeben. Aus diesem Grund ist die Berechnung der Auflösung in lp/mm äußerst nützlich, wenn man Objektive vergleicht und die beste Wahl für bestimmte Sensoren und Anwendungen bestimmt. Im ersten beginnt die Berechnung der Systemauflösung. Beginnend mit dem Sensor ist es einfacher zu bestimmen, welche Objektivspezifikationen erforderlich sind, um die Anforderungen des Geräts oder anderer Anwendungen zu erfüllen. Die höchste vom Sensor zugelassene Frequenz, Nyquist, beträgt effektiv zwei Pixel oder ein Linienpaar.

Definitionsobjektivauflösung, auch Systembildraumauflösung genannt, kann bestimmt werden, indem die Größe in Μm mit 2 multipliziert wird, um ein Paar zu bilden, und durch 1000 dividiert wird, um sie in mm umzuwandeln:

lp/mm=1000/ (2 X Pixel)

Sensoren mit größeren Pixeln haben niedrigere Auflösungsgrenzen. Sensoren mit kleineren Pixeln werden gemäß der obigen Auflösungsformel der Linse eine bessere Leistung erzielen.

Aktiver Sensorbereich

Sie können die maximale Auflösung für das Objekt berechnenansehen. Dazu ist es notwendig, zwischen Indikatoren wie dem Verhältnis zwischen der Größe des Sensors, dem Sichtfeld und der Anzahl der Pixel auf dem Sensor zu unterscheiden. Die Größe des letzteren bezieht sich auf die Parameter des aktiven Bereichs des Kamerasensors, der normalerweise durch die Größe seines Formats bestimmt wird.

Die genauen Proportionen variieren jedoch je nach Seitenverhältnis, und nominale Sensorgrößen sollten nur als Richtlinie verwendet werden, insbesondere für telezentrische Objektive und hohe Vergrößerungen. Die Sensorgröße kann direkt aus der Pixelgröße und der aktiven Pixelanzahl berechnet werden, um einen Test der Objektivauflösung durchzuführen.

Die Tabelle zeigt die Nyquist-Grenze in Verbindung mit den Pixelgrößen einiger sehr häufig verwendeter Sensoren.

| Pixelgröße (µm) | Gekoppelte Nyquist-Grenze (lp / mm) |

| 1, 67 | 299, 4 |

| 2, 2 | 227, 3 |

| 3, 45 | 144, 9 |

| 4, 54 | 110, 1 |

| 5, 5 | 90, 9 |

Mit abnehmender Pixelgröße erhöht sich die zugehörige Nyquist-Grenze in lp/mm proportional. Um den absolut minimal auflösbaren Punkt zu bestimmen, der auf einem Objekt gesehen werden kann, muss das Verhältnis des Sichtfeldes zur Größe des Sensors berechnet werden. Dies wird auch als primäre Augmentation bezeichnet.(PMAG)-Systeme.

Die mit dem System PMAG verbundene Beziehung ermöglicht die Skalierung der Bildraumauflösung. Typischerweise wird beim Entwerfen einer Anwendung nicht in lp/mm angegeben, sondern in Mikron (µm) oder Bruchteilen eines Zolls. Sie können schnell zur endgültigen Auflösung eines Objekts springen, indem Sie die obige Formel verwenden, um die Auswahl der Objektivauflösung z zu vereinfachen. Es ist auch wichtig zu bedenken, dass es viele zusätzliche Faktoren gibt und die obige Einschränkung viel weniger fehleranfällig ist als die Komplexität, viele Faktoren zu berücksichtigen und sie mithilfe von Gleichungen zu berechnen.

Brennweite berechnen

Die Auflösung eines Bildes ist die Anzahl der darin enth altenen Pixel. Bezeichnet in zwei Dimensionen, zum Beispiel 640X480. Berechnungen können für jede Dimension separat durchgeführt werden, aber der Einfachheit halber wird dies oft auf eine reduziert. Um genaue Messungen an einem Bild vorzunehmen, müssen Sie mindestens zwei Pixel für jeden kleinsten Bereich verwenden, den Sie erkennen möchten. Die Größe des Sensors bezieht sich auf einen physikalischen Indikator und wird in der Regel nicht in den Passdaten angegeben. Der beste Weg, die Größe eines Sensors zu bestimmen, besteht darin, sich die Pixelparameter darauf anzusehen und sie mit dem Seitenverhältnis zu multiplizieren. In diesem Fall löst das Auflösungsvermögen des Objektivs die Probleme einer schlechten Aufnahme.

Zum Beispiel hat die Basler acA1300-30um Kamera eine Pixelgröße von 3,75 x 3,75um und eine Auflösung von 1296 x 966 Pixel. Die Sensorgröße beträgt 3,75 µm x 1296 x 3,75 µm x 966=4,86 x 3,62 mm.

Sensorformat bezieht sich auf die physische Größe und hängt nicht von der Pixelgröße ab. Diese Einstellung wird verwendet fürbestimmen, mit welchem Objektiv die Kamera kompatibel ist. Damit sie übereinstimmen, muss das Objektivformat größer oder gleich der Sensorgröße sein. Wenn ein Objektiv mit einem kleineren Seitenverhältnis verwendet wird, wird das Bild vignettiert. Dadurch werden Bereiche des Sensors außerhalb des Randes des Objektivformats dunkel.

Pixel- und Kameraauswahl

Um die Objekte im Bild sehen zu können, muss genügend Abstand zwischen ihnen sein, damit sie nicht mit benachbarten Pixeln verschmelzen, da sie sonst nicht voneinander zu unterscheiden sind. Wenn die Objekte jeweils ein Pixel groß sind, muss die Trennung zwischen ihnen auch mindestens ein Element sein, wodurch ein Linienpaar gebildet wird, das tatsächlich zwei Pixel groß ist. Das ist einer der Gründe, warum es falsch ist, die Auflösung von Kameras und Objektiven in Megapixeln anzugeben.

Eigentlich ist es einfacher, das Auflösungsvermögen eines Systems anhand der Leitungspaarfrequenz zu beschreiben. Daraus folgt, dass mit abnehmender Pixelgröße die Auflösung zunimmt, da Sie kleinere Objekte auf kleineren digitalen Elementen platzieren können, weniger Platz zwischen ihnen haben und dennoch die Entfernung zwischen den aufgenommenen Objekten auflösen.

Dies ist ein vereinfachtes Modell, wie der Sensor der Kamera Objekte erkennt, ohne Rauschen oder andere Parameter zu berücksichtigen, und ist die ideale Situation.

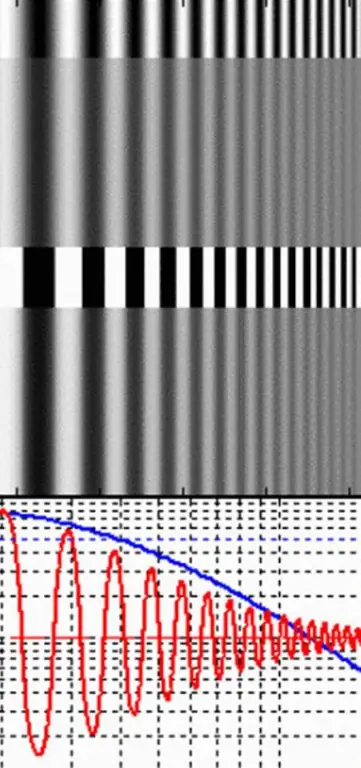

MTF-Kontrasttabellen

Die meisten Objektive sind keine perfekten optischen Systeme. Licht, das durch eine Linse fällt, erfährt einen gewissen Grad an Verschlechterung. Die Frage ist, wie man das auswertetDegradierung? Vor der Beantwortung dieser Frage ist es notwendig, den Begriff „Modulation“zu definieren. Letzteres ist ein Maß für den Kontrast len bei einer gegebenen Frequenz. Man könnte versuchen, reale Bilder zu analysieren, die durch ein Objektiv aufgenommen wurden, um die Modulation oder den Kontrast für Details unterschiedlicher Größe oder Frequenz (Abstand) zu bestimmen, aber das ist sehr unpraktisch.

Stattdessen ist es viel einfacher, die Modulation oder den Kontrast für Paare abwechselnd weißer und dunkler Linien zu messen. Sie werden rechteckige Gitter genannt. Der Linienabstand in einem Rechteckwellengitter ist die Frequenz (v), für die die Modulations- oder Kontrastfunktion der Linse und die Auflösung in cm gemessen werden.

Die maximale Lichtmenge kommt von den hellen Bändern und die minimale von den dunklen Bändern. Wird Licht in Helligkeit (L) gemessen, lässt sich die Modulation nach folgender Gleichung bestimmen:

Modulation=(Lmax - Lmin) / (Lmax + Lmin), wobei: Lmax die maximale Helligkeit der weißen Linien im Gitter und Lmin die minimale Helligkeit der dunklen Linien ist.

Wenn Modulation in Bezug auf Licht definiert wird, wird sie oft als Michelson-Kontrast bezeichnet, weil sie das Verhältnis der Luminanz von hellen und dunklen Bändern zur Messung des Kontrasts verwendet.

Zum Beispiel gibt es ein Rechteckwellengitter mit einer bestimmten Frequenz (v) und Modulation und einen inhärenten Kontrast zwischen dunklen und hellen Bereichen, die von diesem Gitter durch die Linse reflektiert werden. Die Bildmodulation und damit der Linsenkontrast wird für eine gegebene Frequenz gemessenBalken (v).

Die Modulationsübertragungsfunktion (MTF) ist definiert als die Modulation M i des Bildes dividiert durch die Modulation des Stimulus (Objekt) M o, wie in der folgenden Gleichung gezeigt.

|

MTF (v)=M i / M 0 |

USF-Testgitter werden auf 98 % hellem Laserpapier gedruckt. Schwarzer Toner für Laserdrucker hat einen Reflexionsgrad von etwa 10 %. Der Wert für M 0 ist also 88%. Da Film jedoch im Vergleich zum menschlichen Auge einen begrenzteren Dynamikbereich hat, kann man davon ausgehen, dass M 0 im Wesentlichen 100% oder 1 beträgt. Die obige Formel läuft also auf Folgendes hinaus einfache Gleichung:

|

MTF (v)=Mi |

Die MTF len für eine gegebene Gitterfrequenz (v) ist also einfach die gemessene Gittermodulation (Mi), wenn sie durch ein Objektiv auf Film fotografiert wird.

Mikroskopauflösung

Die Auflösung eines Mikroskopobjektivs ist die kürzeste Entfernung zwischen zwei verschiedenen Punkten im Sichtfeld des Okulars, die noch als unterschiedliche Objekte unterschieden werden können.

Wenn zwei Punkte näher beieinander liegen als Ihre Auflösung, erscheinen sie verschwommen und ihre Positionen sind ungenau. Das Mikroskop kann eine hohe Vergrößerung bieten, aber wenn die Linsen von schlechter Qualität sind, wird die resultierende schlechte Auflösung die Bildqualität verschlechtern.

Unten ist die Abbe-Gleichung, wo die Auflösungdie Brechkraft eines Mikroskopobjektivs z ist das Auflösungsvermögen gleich der Wellenlänge des verwendeten Lichts dividiert durch 2 (die numerische Apertur des Objektivs).

Mehrere Elemente beeinflussen die Auflösung eines Mikroskops. Ein auf hohe Vergrößerung eingestelltes optisches Mikroskop kann ein verschwommenes Bild erzeugen, hat aber dennoch die maximale Auflösung des Objektivs.

Die digitale Blende eines Objektivs beeinflusst die Auflösung. Das Auflösungsvermögen eines Mikroskopobjektivs ist eine Zahl, die die Fähigkeit einer Linse angibt, Licht zu sammeln und einen Punkt in einem festen Abstand vom Objektiv aufzulösen. Der kleinste Punkt, der von der Linse aufgelöst werden kann, ist proportional zur Wellenlänge des gesammelten Lichts dividiert durch die numerische Aperturzahl. Daher entspricht eine größere Zahl einer größeren Fähigkeit des Objektivs, einen hervorragenden Punkt im Sichtfeld zu erkennen. Die numerische Apertur des Objektivs hängt auch vom Ausmaß der optischen Aberrationskorrektur ab.

Auflösung des Teleskopobjektivs

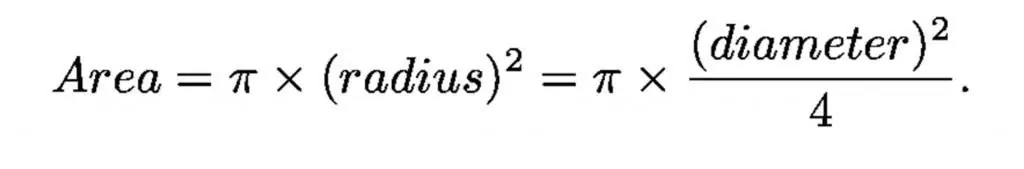

Wie ein Lichttrichter kann ein Teleskop Licht proportional zur Fläche des Lochs sammeln, diese Eigenschaft ist die Hauptlinse.

Der Durchmesser der dunkelangepassten Pupille des menschlichen Auges beträgt knapp 1 Zentimeter, und der Durchmesser des größten optischen Teleskops beträgt 1.000 Zentimeter (10 Meter), sodass das größte Teleskop in der Sammlung eine Million Mal größer ist größer als das menschliche Auge.

Deshalb sehen Teleskope schwächere Objekte als Menschen. Und haben Geräte, die Licht mit elektronischen Erkennungssensoren für viele Stunden akkumulieren.

Es gibt zwei Haupttypen von Teleskopen: linsenbasierte Refraktoren und spiegelbasierte Reflektoren. Große Teleskope sind Reflektoren, weil Spiegel nicht durchsichtig sein müssen. Teleskopspiegel gehören zu den präzisesten Konstruktionen. Der zulässige Fehler auf der Oberfläche beträgt etwa 1/1000 der Breite eines menschlichen Haares - durch ein 10-Meter-Loch.

Spiegel wurden früher aus riesigen, dicken Glasplatten hergestellt, damit sie nicht durchhängen. Heutige Spiegel sind dünn und flexibel, werden jedoch computergesteuert oder auf andere Weise durch Computersteuerung segmentiert und ausgerichtet. Neben der Aufgabe, schwache Objekte zu finden, ist es das Ziel des Astronomen, auch ihre feinen Details zu sehen. Der Grad der Detailerkennbarkeit wird als Auflösung bezeichnet:

- Unscharfe Bilder=schlechte Auflösung.

- Klare Bilder=gute Auflösung.

Aufgrund der Wellennatur von Licht und Phänomenen, die Beugung genannt werden, begrenzt der Durchmesser des Spiegels oder der Linse eines Teleskops seine endgültige Auflösung relativ zum Durchmesser des Teleskops. Die Auflösung bedeutet hier das kleinste erkennbare Winkeldetail. Kleine Werte entsprechen exzellenten Bilddetails.

Radioteleskope müssen sehr groß sein, um eine gute Auflösung zu liefern. Erdatmosphäre istunruhige und unscharfe Teleskopbilder. Terrestrische Astronomen erreichen selten die maximale Auflösung des Apparats. Die turbulente Wirkung der Atmosphäre auf einen Stern nennt man Vision. Diese Turbulenzen lassen die Sterne „funkeln“. Um diese atmosphärischen Unschärfen zu vermeiden, starten Astronomen Teleskope ins All oder platzieren sie auf hohen Bergen mit stabilen atmosphärischen Bedingungen.

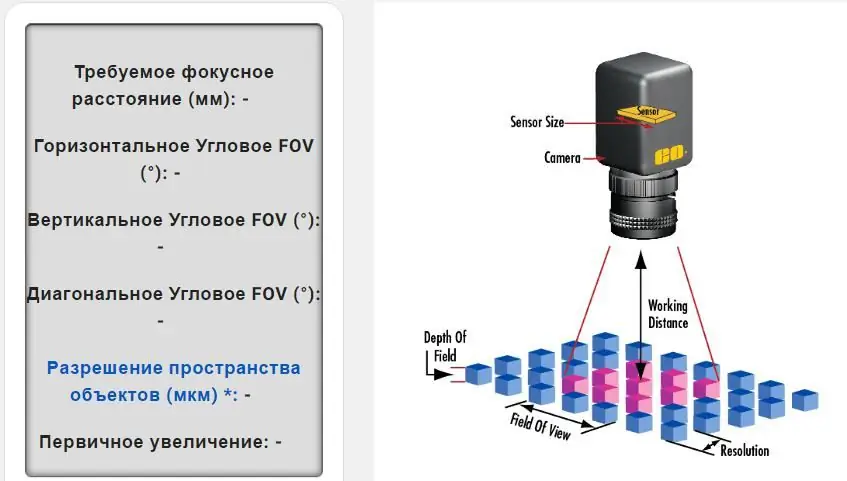

Beispiele zur Parameterberechnung

Daten zur Bestimmung der Canon-Objektivauflösung:

- Pixelgröße=3,45 µm x 3,45 µm.

- Pixel (H x V)=2448 x 2050.

- Gewünschtes Sichtfeld (horizontal)=100 mm.

- Sensorauflösungsgrenze: 1000/2x3, 45=145 lp / mm.

- Sensorabmessungen:3,45x2448/1000=8,45 mm3, 45x2050/1000=7,07 mm.

- PMAG:8, 45/100=0,0845 mm.

- Messobjektivauflösung: 145 x 0,0845=12,25 lp/mm.

Eigentlich sind diese Berechnungen ziemlich komplex, aber sie helfen Ihnen, ein Bild basierend auf Sensorgröße, Pixelformat, Arbeitsabstand und Sichtfeld in mm zu erstellen. Die Berechnung dieser Werte bestimmt das beste Objektiv für Ihre Bilder und Anwendung.

Probleme der modernen Optik

Leider führt die Verdoppelung der Sensorgröße zu zusätzlichen Problemen für Objektive. Einer der Hauptparameter, der die Kosten eines Bildobjektivs beeinflusst, ist das Format. Das Entwerfen eines Objektivs für einen Sensor mit größerem Format erfordertzahlreiche optische Einzelkomponenten, die größer und die Übertragung des Systems steifer sein sollten.

Ein Objektiv, das für einen 1-Zoll-Sensor entwickelt wurde, kann fünfmal so viel kosten wie ein Objektiv, das für einen ½-Zoll-Sensor entwickelt wurde, selbst wenn es nicht die gleichen Spezifikationen mit begrenzter Pixelauflösung verwenden kann. Die Kostenkomponente muss vor dem Wie berücksichtigt werden um das Auflösungsvermögen eines Objektivs zu bestimmen.

Die optische Bildgebung steht heute vor mehr Herausforderungen als noch vor zehn Jahren. Die Sensoren, mit denen sie verwendet werden, haben viel höhere Anforderungen an die Auflösung, und Formatgrößen werden gleichzeitig sowohl kleiner als auch größer getrieben, während die Pixelgröße weiter schrumpft.

In der Vergangenheit hat die Optik das Abbildungssystem nie begrenzt, heute schon. Während eine typische Pixelgröße etwa 9 µm beträgt, liegt eine viel häufigere Größe bei etwa 3 µm. Diese 81-fache Erhöhung der Punktdichte hat ihren Tribut von der Optik gefordert, und obwohl die meisten Geräte gut sind, ist die Objektivauswahl jetzt wichtiger denn je.